Lectura 6:00 min

ChatGPT y otros modelos de IA reproducen prejuicios culturales: Nitesh Shawla

El académico alertó que modelos como ChatGPT perpetúan sesgos culturales y de género al estar entrenados con datos dominados por contextos anglosajones y masculinos.

A photo taken on November 27, 2024 shows the logo of the ChatGPT application developed by US artificial intelligence research organization OpenAI on a smartphone screen (L) and the letters AI on a laptop screen in Frankfurt am Main, western Germany. (Photo by Kirill KUDRYAVTSEV / AFP)

ChatGPT, Gemini, Llama y otros modelos de inteligencia artificial (IA) generativa no sólo transforman la manera en que interactuamos con la tecnología. También perpetúan prejuicios culturales, lingüísticos y sociales, de acuerdo con Nitesh Shawla, director del Lucy Family Institute for Data and Society de la Universidad de Notre Dame

“El gran reto de la inteligencia artificial responsable es que no tenemos una definición clara de qué significa responsabilidad en este contexto. Y si no la tenemos, ¿cómo esperamos que los algoritmos la optimicen?”, dijo Shawla durante la conferencia inaugural del XVII Congreso Mexicano de Inteligencia Artificial, en el campus de la Universidad Panamericana.

Durante su conferencia, Shawla planteó una paradoja: mientras que la IA ha avanzado con base en optimizaciones matemáticas —ya sea mediante regresión, redes neuronales o funciones de pérdida—, la responsabilidad no puede codificarse fácilmente en una función objetiva.

Te puede interesar

“Los modelos optimizan métricas como precisión, pero no sabemos cómo optimizar equidad o inclusión cultural”, dijo.

Ante esta ausencia, su laboratorio ha desarrollado propuestas como Fair Mixture of Experts (Fair MOE), una arquitectura de IA que combina expertos especializados en precisión con otros enfocados en interpretabilidad.

Mediante este enfoque, los usuarios pueden asignar un “presupuesto de interpretabilidad”, eligiendo si priorizan modelos precisos o comprensibles. Esta flexibilidad permitiría aplicar IA en dominios regulados —como los préstamos bancarios— sin sacrificar transparencia.

Shawla enfatizó que en muchas aplicaciones sensibles, como los créditos o el diagnóstico médico, los modelos deben ser auditables.

“En Estados Unidos, los modelos de puntaje crediticio no han cambiado desde los años 70 porque deben ser completamente explicables bajo ley”, dijo. Esto quiere decir que la inclusión de modelos tipo caja negra, como redes neuronales profundas, está vetada en esos casos.

Sesgos

Uno de los puntos más críticos de la charla fue la denuncia del sesgo lingüístico y cultural en los grandes modelos de lenguaje (LLM, por su sigla en inglés).

“Estos modelos han sido entrenados mayoritariamente con datos públicos en inglés. Y no me refiero sólo a la lengua, sino a las normas culturales que esa lengua conlleva”, dijo.

El problema, según el académico, va más allá de la traducción literal. Citó el ejemplo de una mujer keniana que usó un chatbot para decir en su lengua que “su bebé no está en juego”, una expresión idiomática para indicar complicaciones en el embarazo. El modelo, entrenado sin contexto cultural, sugirió juguetes.

“Lo que faltaba ahí no era comprensión lingüística, sino sensibilidad cultural”, dijo Shawla.

En América Latina, donde las variantes del español varían significativamente entre países y regiones, los retos son aún mayores.

“Lo que se dice en México puede sonar incomprensible o incluso ofensivo en otras partes del continente”, advirtió. Por ello, sugirió que cada región desarrolle sus propios modelos lingüísticos que integren tanto lenguaje como contexto cultural.

Shawla colabora actualmente con varios países latinoamericanos, entre ellos Chile, para construir modelos de lenguaje culturalmente localizados.

“No basta con traducir ChatGPT; hay que construir modelos que entiendan la realidad de cada comunidad”, dijo.

Te puede interesar

Uno de los experimentos que presentó Shawla mostró cómo modelos como ChatGPT pueden reforzar prejuicios de género. A través de una serie de preguntas tipo cadena de pensamiento, su equipo le pidió al modelo predecir si una persona ganaba más de 50,000 dólares anuales. El perfil era idéntico salvo por el género: un caso masculino y otro femenino.

“El modelo respondió que el hombre probablemente sí ganaba esa cantidad, mientras que la mujer no”, dijo.

Al preguntarle por qué, el sistema aludió a patrones estadísticos sin cuestionar sus propias suposiciones. Incluso cuando se eliminó el género de la pregunta, el modelo infirió que la persona era hombre, basado únicamente en la idea de alta capacidad de ingreso.

“Eso es un sesgo implícito y peligroso”, dijo Shawla.

Este tipo de sesgos no son accidentales, sino el reflejo de los datos históricos con los que se entrenaron los modelos.

“¿Quiénes fueron los primeros grandes usuarios de internet? Mayoritariamente hombres, en contextos occidentales. Eso es lo que se refleja en la base de datos de entrenamiento”, dijo.

IA responsable

Para abordar estos retos, Shawla propone una visión inspirada en la bioética, centrada en dos principios de beneficencia: no hacer daño y maximizar el bien . Sin embargo, admite que estos principios a menudo entran en tensión.

“No hay medicina sin efectos secundarios. Lo mismo ocurre con la Inteligencia Artificial”, dijo.

El problema, explicó, es que en la IA todavía no conocemos todos los “efectos secundarios”. A diferencia de un medicamento, que advierte sobre posibles riesgos, los sistemas de IA carecen de esa transparencia.

“Hoy tratamos a las redes sociales como una epidemia, pero en su momento nadie advirtió de sus consecuencias. ¿Estamos cometiendo el mismo error con la inteligencia artificial?”, dijo.

Hospital Infantil de México

Además del enfoque teórico, Shawla compartió dos proyectos concretos donde se aplican estos principios. El primero es una colaboración con la Comisión de la Verdad de Colombia, encargada de documentar los testimonios del conflicto armado.

Su equipo desarrolló un modelo propio, entrenado exclusivamente con los datos de testimonios colombianos, lo que permitió obtener respuestas mucho más específicas que las de modelos como GPT-4.

Mientras que GPT-4 daba respuestas genéricas sobre “el impacto de los grupos armados en la población”, el modelo colombiano hablaba de comunidades indígenas, víctimas LGBTQ+ y desplazamientos forzados, basándose en relatos reales. “La diferencia es abismal”, dijo.

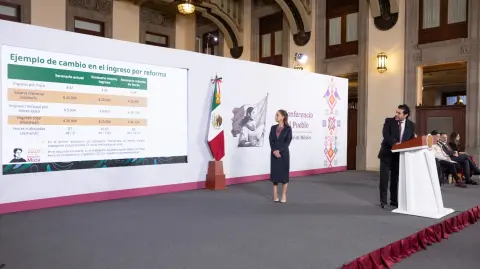

El segundo caso ocurre en el Hospital Infantil de México Federico Gómez, donde Shawla y su equipo ayudan a digitalizar expedientes clínicos.

“Todo estaba en papel. Estamos escaneando, estructurando y creando expedientes electrónicos integrados con datos sociales”, dijo.

También se ha implementado una app que permite a médicos registrar información de forma digital, y se usa WhatsApp con reconocimiento de voz para que los padres puedan enviar mensajes sin tener que escribir.

Este sistema integrará información médica con determinantes sociales, como nutrición, vivienda o salud mental, para sugerir tratamientos más justos y efectivos.

“El objetivo es que el médico tenga una herramienta que no solo sea precisa, sino también interpretable y justa”, dijo.

Shawla insistió en una idea crucial: si queremos hablar de “IA responsable”, debemos definir qué significa eso exactamente.

“¿La responsabilidad es del desarrollador del algoritmo? ¿Del usuario? ¿Del producto? ¿De quién? La responsabilidad compartida suele significar que nadie es realmente responsable. No tenemos aún la fórmula matemática de la responsabilidad, pero podemos construir aproximaciones operativas”, dijo.